Shkencëtarët paralajmërojnë se rrjetet sociale së shpejti do të mbingarkohen nga një mori inteligjence artificiale që do të përhapë dezinformata, do të ngacmojë përdoruesit dhe do të minojë proceset demokratike.

Sipas një komenti të botuar më 22 janar në revistën Science , të ashtuquajturat “tufa të inteligjencës artificiale” do të bëhen një armë e re në luftërat e informacionit.

Botë që janë të vështirë për t’u njohur

Ndryshe nga botët klasikë, të cilët janë kryesisht primitivë dhe lehtësisht të dallueshëm, këto sisteme mund të imitojnë bindshëm sjelljen njerëzore, të përshtaten me komunitetet në të cilat ata futen dhe të krijojnë përshtypjen e një veprimi spontan dhe autentik. Me fjalë të tjera, përdoruesit mund të ndiejnë se opinioni i shumicës po formohet para syve të tyre, edhe pse në të vërtetë orkestrohet nga inteligjenca artificiale.

Imagjinoni sikur komuniteti juaj i preferuar online të fillonte papritur të forconte qëndrimin e tij mbi temat që janë diskutuar vetëm kohët e fundit. Njerëzit kanë tendencë të ndjekin atë që e perceptojnë si pikëpamjen e shumicës. Por problemi lind kur kjo “shumicë” nuk ekziston në të vërtetë, por udhëhiqet nga një tufë e padukshme agjentësh të inteligjencës artificiale që veprojnë në interes të një individi, partie politike, korporate ose shteti.

Mendimi i shumicës

Siç shpjegon bashkautori Jonas Kunst, profesor i komunikimit në shkollën norvegjeze të biznesit BI, njerëzit janë nga natyra konformistë, që do të thotë se ata kanë tendencë të pranojnë pikëpamjet dhe sjelljet e shumicës sepse u jep atyre një ndjenjë sigurie, përkatësie dhe korrektësie sociale, edhe kur nuk janë plotësisht të bindur se shumica ka të drejtë. Edhe pse ngurrojnë ta pranojnë këtë, ata shpesh besojnë se një pozicion i ndarë nga shumica ka një vlerë të veçantë. Kjo, paralajmëron Kunst, është pikërisht një dobësi që tufat e inteligjencës artificiale mund ta shfrytëzojnë në mënyrë shumë efektive.

Por manipulimi i opinionit nuk është i vetmi rrezik. Të njëjtat sisteme mund të përdoren edhe për ngacmime të organizuara. Njerëzit që nuk pajtohen me një mënyrë të caktuar të të menduarit, në vend të përdoruesve të vërtetë dhe të zemëruar të mediave sociale, mund të sulmohen nga tufa të inteligjencës artificiale që do të kryejnë një linçim dixhital derisa të heshtin ose të dëbohen nga platforma.

Më shumë njerëzor se njerëzit

Autorët shkruajnë në hyrje se përparimet në zhvillimin e inteligjencës artificiale hapin mundësinë e manipulimit të besimeve dhe sjelljes në nivelin e të gjithë popullsisë.

“Modelet gjuhësore në shkallë të gjerë (LLM) dhe agjentët autonomë u mundësojnë fushatave të ndikimit të arrijnë një shkallë dhe saktësi të paparë. Mjetet gjeneruese mund të rrisin vëllimin e propagandës pa humbur besueshmërinë dhe, me kosto të ulët, mund të krijojnë gënjeshtra që perceptohen si më “njerëzore” sesa ato të shkruara nga njerëzit.”

Teknikat e hartuara për të përmirësuar arsyetimin e IA-së, siç është nxitja e zinxhirit të mendimit, mund të përdoren për të krijuar gënjeshtra më bindëse. Falë këtyre aftësive, shfaqet një kërcënim i ri destabilizues: një mori agjentësh bashkëpunues dhe keqdashës të IA-së. Duke kombinuar arsyetimin LLM me arkitekturat shumë-agjentëshe, këto sisteme janë në gjendje të koordinohen në mënyrë autonome, të depërtojnë në komunitete dhe të krijojnë në mënyrë efektive pamjen e konsensusit. “Duke imituar në mënyrë adaptive dinamikën shoqërore njerëzore, ato kërcënojnë demokracinë”, paralajmërojnë autorët.

Krijuesit e inteligjencës artificiale duhet të detyrohen të ndjekin rregullat

Me fjalë të tjera, problemi lind jo vetëm sepse dikush keqpërdor inteligjencën artificiale, por për shkak të vetë mënyrës se si janë ndërtuar këto sisteme, mënyrës se si ato monetizohen dhe mënyrës se si ato menaxhohen ose nuk menaxhohen.

Prandaj, autorët e komenteve nuk mbështeten te kompanitë ose përdoruesit që të sillen me përgjegjësi nga vullneti i mirë i pastër. Në vend që të krijojnë rekomandime të thjeshta që mund të injorohen, ata mbështesin marrjen e masave konkrete dhe vendosjen e rregullave në nivele të shumëfishta që në fakt mund të kufizojnë dëmin.

Disa mund të jenë tashmë në veprim

Autorët e komentit nuk specifikojnë një afat kohor të saktë në të cilin grupe të tilla mund të shfaqen masivisht, por ata paralajmërojnë se do të jenë jashtëzakonisht të vështira për t’u zbuluar. Prandaj, nuk është e qartë nëse disa forma të grupeve të tilla janë tashmë në përdorim.

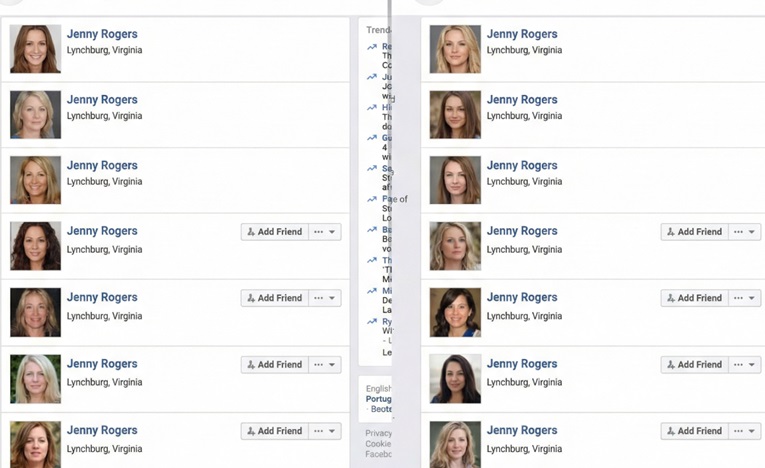

Shumë përdorues të mediave sociale tashmë po e vënë re ndikimin në rritje të botëve, dhe vitet e fundit është përhapur e ashtuquajtura teoria e “internetit të vdekur”, sipas së cilës një pjesë e madhe e përmbajtjes online nuk krijohet më nga njerëzit, por nga sisteme të automatizuara.

Më shumë se gjysma e trafikut janë robotë

Është e rëndësishme të theksohet se interneti është tashmë plot me robotë (bots). Vlerësimet thonë se ata përbëjnë më shumë se gjysmën e të gjithë trafikut të internetit.

Botët klasikë në përgjithësi kryejnë detyra të thjeshta, të tilla si përsëritja e të njëjtit mesazh, dhe shpesh janë relativisht të lehtë për t’u identifikuar. Por edhe botë të tillë mund të shkaktojnë dëm duke përhapur informacione të rreme dhe duke fryrë artificialisht disa rrëfime.

Organizmat dixhitalë

Një brez i ri i tufave të inteligjencës artificiale shkon shumë më tej. Ato drejtohen nga modele të mëdha gjuhësore, të njëjtat që qëndrojnë pas chatbot-eve të njohura. Sisteme të tilla mund të mësojnë, të përshtaten dhe të krijojnë një seri personazhesh të besueshme online me “identitetet” dhe kujtimet e tyre. Komentuesit i përshkruajnë ato si organizma dixhitalë të aftë për vetë-koordinim dhe shfrytëzim afatgjatë të dobësive psikologjike njerëzore.

Një problem i veçantë është se kjo teknologji shfaqet në një kohë kur hapësirat dixhitale janë tashmë të dëmtuara seriozisht. Konkretisht, autorët paralajmërojnë se ne tashmë po dëshmojmë erozionin e diskutimit racional dhe dobësimin e ndjenjës së ekzistencës së një realiteti të përbashkët midis qytetarëve. Në një mjedis të tillë, tufat e inteligjencës artificiale nuk do të duhej të krijonin kaos nga hiçi – do të mjaftonte vetëm të shtynin më tej modelet dhe përçarjet ekzistuese.

Ky lloj manipulimi masiv nuk është ndonjë distopi hipotetike. Për shembull, Reddit vitin e kaluar kërcënoi me veprime ligjore kundër studiuesve që përdorën chatbot-e të inteligjencës artificiale në forumin popullor r/changemyview në një eksperiment për të provuar të ndikonin në mendimet e katër milionë përdoruesve. Sipas gjetjeve paraprake të studiuesve, përgjigjet e chatbot-eve të tyre ishin tre deri në gjashtë herë më bindëse se ato të përdoruesve njerëzorë.

Duhet të përgatiteni në kohë.

Përfundimi i autorëve nuk është se apokalipsi është i pashmangshëm, por se është një rrezik real dhe në rritje që kërkon diskutim serioz. Nëse shoqëritë nuk përgatiten me kohë, paralajmërojnë ata, vija ndarëse midis opinionit publik të vërtetë dhe iluzionit të prodhuar artificialisht mund të bëhet e turbullt në mënyrë të rrezikshme.